MCP(Model Context Protocol)的定义与核心目标

MCP(Model Context Protocol)的定义与核心目标

2ChaosMCP(Model Context Protocol)的定义与核心目标

MCP(Model Context Protocol,模型上下文协议)是一种由 Anthropic 于 2024 年 11 月提出的开放协议,旨在为大型语言模型(LLM)提供标准化接口,使其能够安全、高效地连接外部数据源、工具和服务。它通过客户端-服务器架构,将 LLM 应用(如 Claude Desktop、IDE 工具)与本地或远程资源(如数据库、API、文件系统)无缝集成,解决传统 AI 交互中数据孤岛、功能受限和安全风险等问题。

MCP 解决的核心问题

数据隔离与实时性不足

LLM 的训练数据通常是静态的,无法访问实时信息(如天气、股票行情)或用户私有数据(如本地文件、数据库)。MCP 通过标准化协议允许 LLM 动态获取最新数据,例如通过天气 API 服务器实时查询天气警报。

功能扩展性差

传统 LLM 无法直接执行外部操作(如发送邮件、控制设备)。MCP 通过“工具”(Tools)定义可执行功能,例如通过 GitHub 服务器自动创建 Issue 或查询数据库。

集成成本高

不同 LLM 平台(如 OpenAI、Claude)的 Function Calling 接口不兼容,需重复开发适配。MCP 提供统一协议,使开发者只需一次集成即可支持所有兼容 MCP 的 LLM。

安全性挑战

敏感数据(如本地文件)若直接上传至云端模型存在泄露风险。MCP 允许数据通过本地服务器处理,仅传输必要信息,降低风险。

MCP 与 LLM 的协同关系

LLM 作为核心引擎

LLM(如 Claude、GPT)负责处理自然语言交互和生成逻辑,而 MCP 作为中间层,为 LLM 提供扩展能力。例如,当用户要求“分析销售数据”时,LLM 通过 MCP 调用数据库工具获取数据,再生成分析报告。

动态上下文管理

MCP 通过“资源”(Resources)和“提示模板”(Prompts)为 LLM 提供结构化上下文。例如,预定义的代码分析模板可帮助 LLM 更精准地定位代码错误。

生态化工具支持

MCP 服务器可集成多样化工具(如 GitHub、Slack、AWS),使 LLM 从“聊天机器人”升级为“智能代理”。例如,用户可直接要求 LLM“创建会议日程并同步到 Google Calendar”,而无需手动操作。

技术实现与典型应用

架构设计

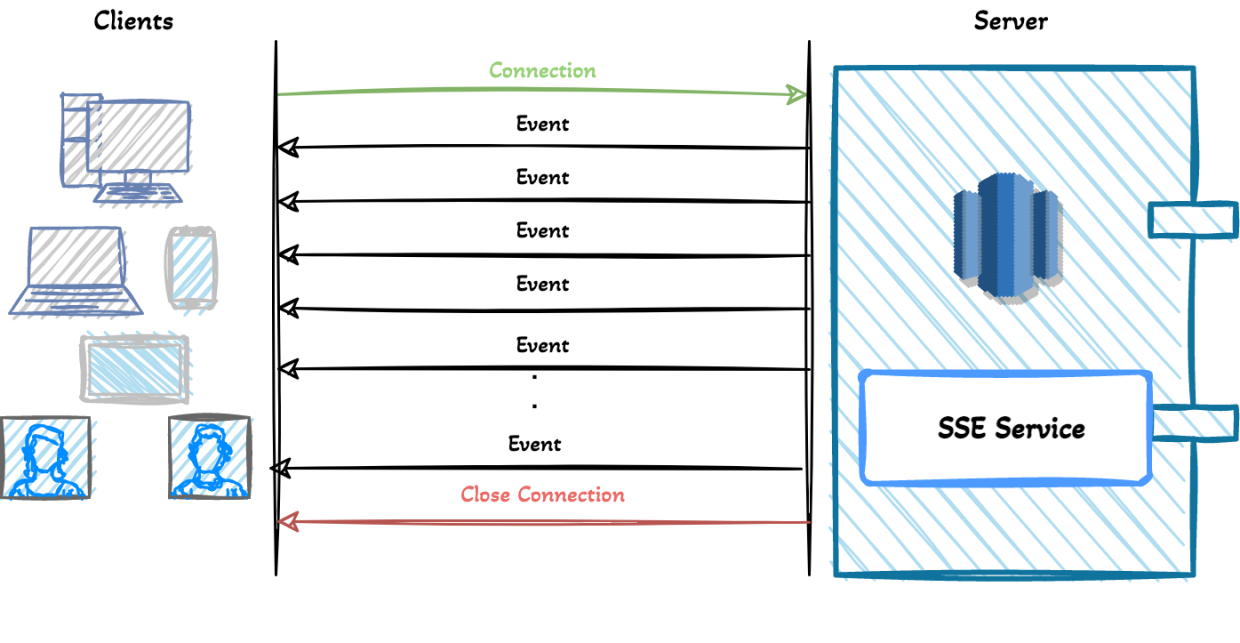

- 客户端-服务器模型:MCP 主机(如 Claude Desktop)通过协议连接多个服务器,每个服务器提供特定功能(如文件访问、API 调用)。

- 三类核心功能:

- 资源:类似 REST API 的 GET 请求,提供数据(如读取本地文件)。

- 工具:类似 POST 请求,执行操作(如发送邮件、调用代码)。

- 提示模板:预定义交互流程,提升任务一致性(如多步骤数据分析模板)。

开发示例

使用 TypeScript SDK 可在几分钟内构建 MCP 服务器。例如,一个天气查询服务器可提供“获取天气预报”工具,LLM 通过参数调用并返回结构化结果。

行业应用

- 开发场景:IDE 工具通过 MCP 集成代码库和 GitHub,实现自动 Bug 修复。

- 企业场景:通过 MCP 连接内部数据库和 CRM 系统,LLM 可生成客户洞察报告。

未来发展与挑战

- 趋势:MCP 可能成为 AI Agent 的基础设施标准,支持多模态(图像、语音)和分布式模型协作。

- 挑战:需平衡开放性与安全性,防止恶意工具调用;同时需推动跨平台协议标准化。

总结:MCP 通过标准化协议解决了 LLM 与外部世界连接的三大瓶颈——数据隔离、功能受限和集成碎片化,使其从封闭的“文本生成器”进化为开放的“智能执行者”。